| 開発工程 | 攻撃分類 | 攻撃手法 | 防御手法 |

|---|---|---|---|

|

学習データの収集/作成 (Data Preparation) |

データ汚染 |

|

|

|

モデルの学習/作成 (Model Fitting) |

モデル汚染 |

|

|

|

モデルの設置 (Deployment) |

敵対的サンプル | ||

| データ窃取 |

|

||

|

|||

| モデル窃取 |

|

特徴量の絞り込み (Feature Squeezing)

敵対的サンプルの防御手法。AIへの入力データのカラービット深度を減らしたり、画像の平滑化を行うことで、誤分類の原因となる摂動の影響を抑制します。

特徴量の絞り込みは、敵対的サンプルに対する防御の1手法です。2017年に論文「Feature Squeezing: Detecting Adversarial Examples in Deep Neural Networks」で提案されました。

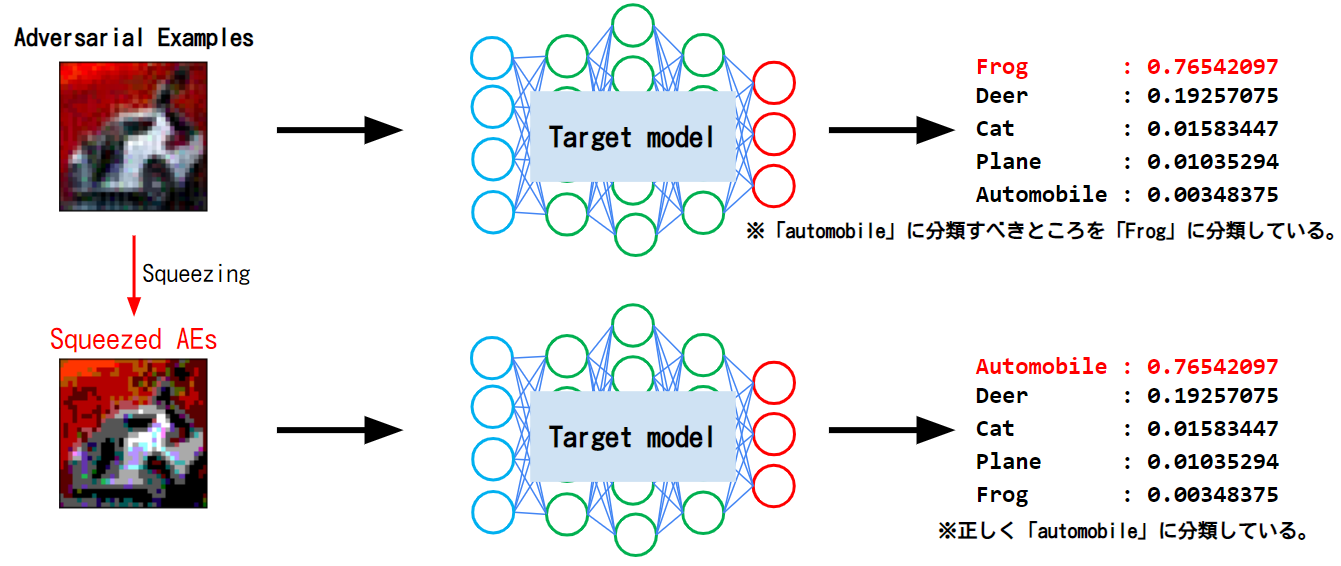

本手法は、主に画像を使用した敵対的サンプルに対する防御手法です。摂動が加えられた入力データ(画像)のカラービット深度を減らすことや、(画像処理の)空間フィルタを利用して入力画像を平滑化することで、入力データに加えられた摂動を無効化します。以下の図は、特徴量の絞り込みによって敵対的サンプルが無効化された様子を表しています。

上図に示すように、AI(Target model)は特徴量の絞り込みを行っていない敵対的サンプル(Adversarial Examples)を誤分類しているのに対し、特徴量の絞り込みを行った敵対的サンプル(Squeezed AEs)は正しく分類していることが分かります。

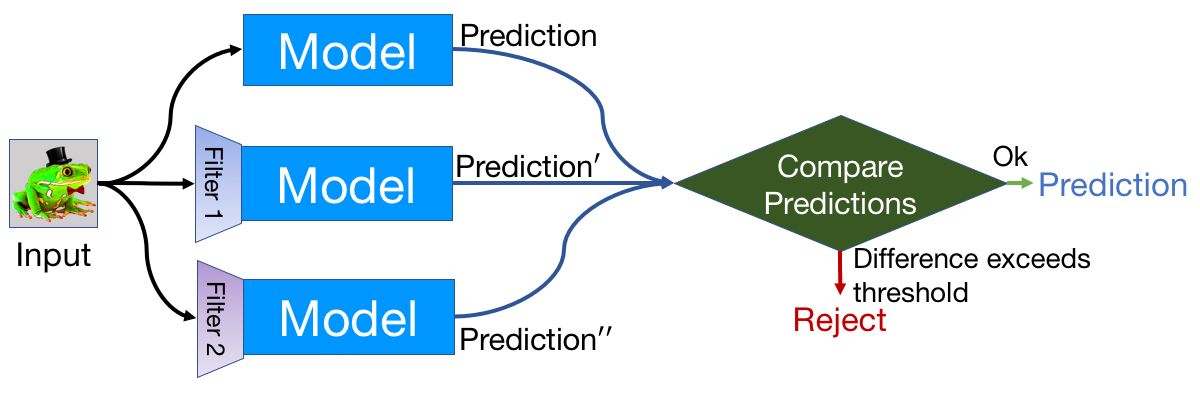

なお、本手法を提案した研究者らは、以下に示すように生の入力データと特徴量の絞り込みを行った入力データをそれぞれAIに分類させ、分類結果に差異が出た場合、入力データを不正(敵対的サンプル)と判断して除外する方法も提案しています。

このように、入力データに変化を加えることは、敵対的サンプルに対する有効な対策になり得ます。

なお、本手法と近しいコンセプトとして、入力データ(画像)を圧縮することで、摂動を無効化する試みも提案されています。以下に代表的な手法を示します。

より詳細な内容を知りたい方は、論文「Feature Squeezing: Detecting Adversarial Examples in Deep Neural Networks」をご参照ください。