| 開発工程 | 攻撃分類 | 攻撃手法 | 防御手法 |

|---|---|---|---|

|

学習データの収集/作成 (Data Preparation) |

データ汚染 |

|

|

|

モデルの学習/作成 (Model Fitting) |

モデル汚染 |

|

|

|

モデルの設置 (Deployment) |

敵対的サンプル | ||

| データ窃取 |

|

||

|

|||

| モデル窃取 |

|

汚染データの検知 (Activation Clustering)

データ汚染の防御手法。クラスタリング技術を使用することで、AIへのバックドア設置を目的として学習データに注入された汚染データを検知します。

汚染データの検知(Activation Clustering)は、データ汚染攻撃に対する防御の1手法です。2018年に論文「Detecting Backdoor Attacks on Deep Neural Networks by Activation Clustering」で提案されました。

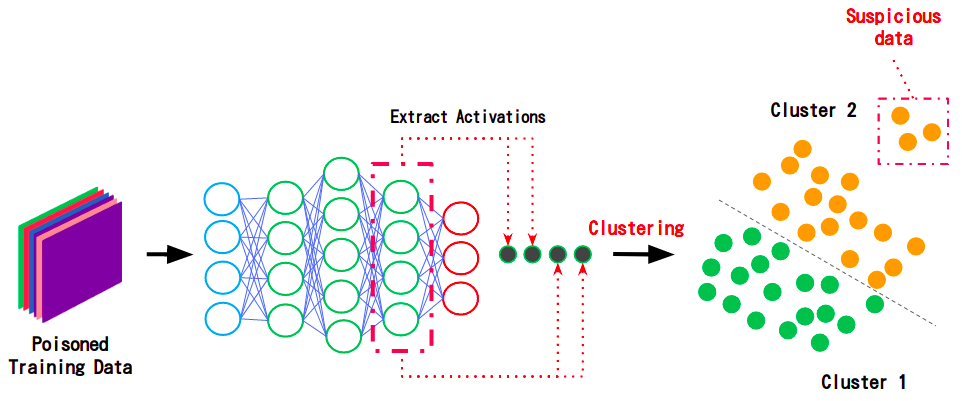

本手法は、汚染データが含まれている可能性のあるデータセットを分類器に入力し、その際の隠れ層(中間層)のActivation値をクラスタリングすることで汚染データを検知します。以下の図は、Activation Clusteringによって汚染データが検知された様子を表しています。

上図に示すように、汚染データが含まれている可能性のあるデータセット(Poisoned Training Data)を分類器に入力し、各入力データに対する隠れ層のActivation値を抽出します(Extract Activations)。

ここで、同じラベルが付けられたデータであっても、(特徴量とラベルが正しく紐づいている)正常データと、特徴量とラベルに乖離がある汚染データではActivation値に差異が生じます。この差異をクラスタリング技術で選り分ける(Clustering)ことで、汚染データを検知します(Suspicious data)。

クラスタリング技術自体は目新しいものではありませんが、分類器のActivation値に着目することで、Deep LearningベースのAIに対する「データ汚染」の有効な対策になり得ます。なお、Activation Clusteringはその手法の特性上、汚染データのみならず、(意図的・偶発的に関わらず)ラベル付けに誤りのあるミスラベル・データも検知することができます。

より詳細な内容を知りたい方は、論文「Detecting Backdoor Attacks on Deep Neural Networks by Activation Clustering」をご参照ください。