| 開発工程 | 攻撃分類 | 攻撃手法 | 防御手法 |

|---|---|---|---|

|

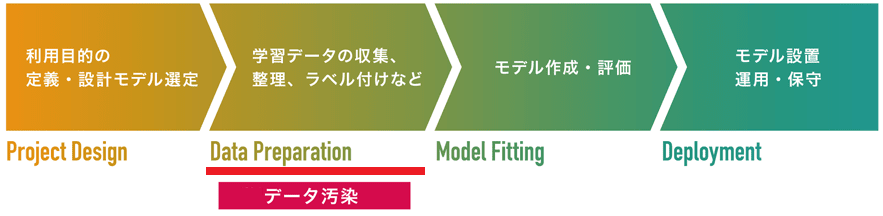

学習データの収集/作成 (Data Preparation) |

データ汚染 |

|

|

|

モデルの学習/作成 (Model Fitting) |

モデル汚染 |

|

|

|

モデルの設置 (Deployment) |

敵対的サンプル | ||

| データ窃取 |

|

||

|

|||

| モデル窃取 |

|

Convex Polytope Attack

AIにバックドアを設置する手法。攻撃者は細工した汚染データを学習データに注入し、これをAIに学習させることで、特定の入力データを攻撃者が意図したクラスに誤分類させることができます。汚染データは見た目に違和感がないため、AI開発者が学習データ作成時にデータの異常を検知することは困難です。

Convex Polytope Attackは、学習データの収集/作成工程を狙った「データ汚染攻撃」の1手法です。

2019年に論文「Transferable Clean-Label Poisoning Attacks on Deep Neural Nets」で提案されました。Feature Collision Attackなどの従来のデータ汚染攻撃手法との大きな違いは、攻撃のステルス性が高く攻撃検知が難しいこと、また、攻撃者が攻撃対象となるAIの内部構造を把握せずとも攻撃できることにあります。

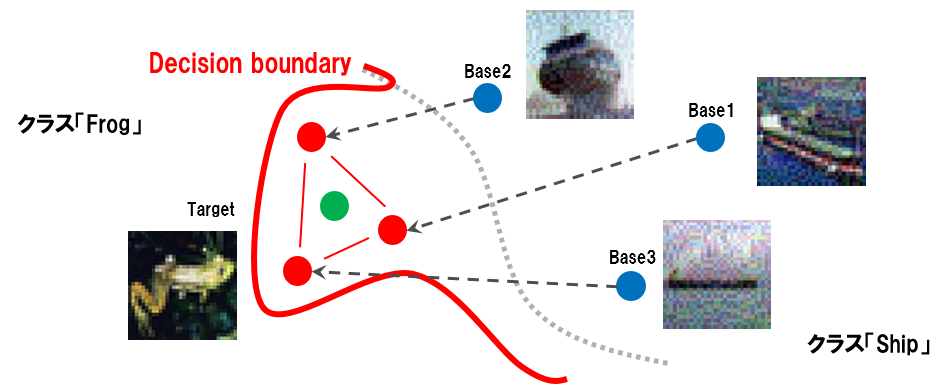

以下の図は、Convex Polytope Attackによって攻撃対象となるAIの決定境界が歪められた様子を表しています。青丸が汚染データの基になるベース画像(船画像)、赤丸がベース画像に摂動を加えて作成した汚染データ、そして、緑丸がトリガー(蛙の画像)を表しています。また、灰色の点線が本来あるべき決定境界、赤色の線が汚染データを学習することで歪められた決定境界を表しています。

図の通り、複数の汚染データでトリガーを取り囲むことで、トリガー(蛙画像)を船クラスに引きずり込むように決定境界が歪められていることが分かります。このため、攻撃を受けたAIにトリガーが入力されると、見た目は蛙にもかかわらず、船クラスに分類されてしまうことになります。

Convex Polytope Attackは、トリガーを複数の汚染データで取り囲むことができれば攻撃が成功するため、大量の摂動を加えて汚染データの特徴量をトリガーに近似させる必要がありません。それゆえに、汚染データの見た目に違和感が生じにくく、攻撃検知が困難となります。また、特徴量の近似が不要なことから、攻撃者は攻撃対象AIの内部構造を把握する必要がなく、ブラックボックスで攻撃することが可能となります。

より詳細な内容を知りたい方は、解説ブログをご参照ください。